Klimaatmodellen

18/02/2019 17:40 - Geplaatst door Tom van Leeuwen

Computermodellen hebben iets magisch. Gezien er supercomputers bij betrokken zijn die staan opgesteld bij bekende universiteiten of gezaghebbende overheidsinstellingen, wordt

modeloutput vaak beschouwd als een substituut voor de werkelijkheid.

Maar dat is het niet.

Een computermodel is niets meer dan een simulatie van de werkelijkheid. Hoe krachtig de computer ook is,

de nauwkeurigheid van een model hangt af van de regels die het definiëren. Als een van de modelregels specificeert dat "1+1=3", zal de uitvoer van het model altijd verkeerd zijn, zelfs als je het uitvoert op de snelste beschikbare supercomputer.

Klimaat "wetenschap" is sterk afhankelijk van modellen. Er zijn duizenden klimaat computermodellen die proberen het klimaat voor de komende decennia en zelfs eeuwen te voorspellen. Alle IPCC-rapporten zijn gebaseerd op deze modellen en overheden implementeren de beleidsaanbevelingen uit deze IPCC-rapporten.

Uiteraard zonder zelfs maar te controleren of de modellen kloppen, want als ze dat zouden doen, zou iedere normaal denkende mens die aanbevelingen nog eens nader bestuderen.

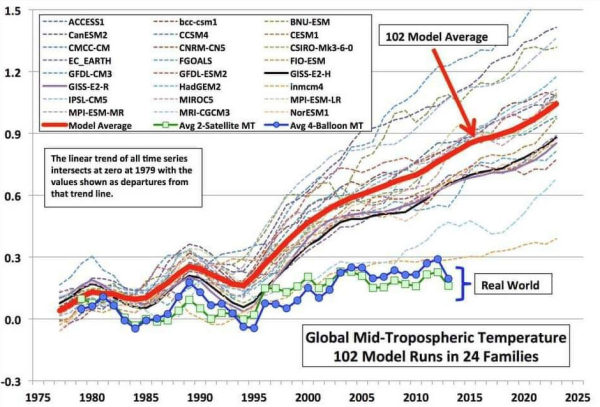

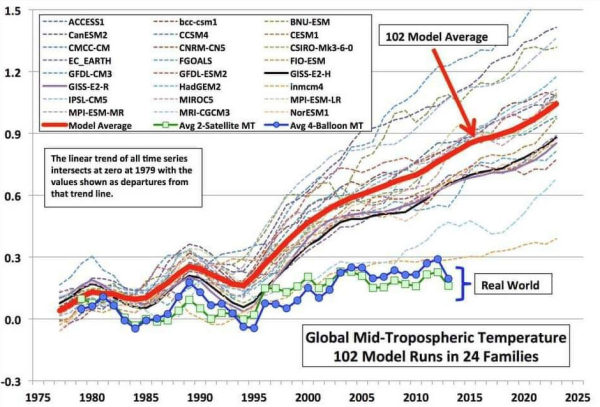

In de bovenstaande grafiek zien we de wereldwijde temperatuurvoorspellingen van 32 verschillende klimaatmodellen die door het IPCC worden gebruikt. Het eerste wat de aandacht trekt is

het grote verschil tussen de modellen.

Er is maar één realiteit, dus kan er maar één model gelijk hebben en

moeten alle andere modellen fout zijn!

In elk normaal wetenschappelijk proces zou dit automatisch elke conclusie op basis van deze gegevens diskwalificeren, maar in de klimaat-"wetenschap" wordt dit "opgelost" door het gemiddelde van de foute modellen te gebruiken. Nee, ik verzin dit niet, zo werkt het en ja, ze noemen het "wetenschap".

De dikke rode lijn in de grafiek toont

het gemiddelde van 102 foute modellen die worden gebruikt in de IPCC-rapporten.

De tweede duidelijke tekortkoming van deze modellen is het feit dat

ze de werkelijke metingen niet voorspellen. En ze zitten en niet 5% of 10% naast..... Het gemiddelde model voorspelt dat de globale temperatuuranomalie over de 40-jarige periode van 1977 tot 2017

drie keer zo hoog is als de gemeten anomalie.

In elke andere wetenschappelijke discipline zouden modellen met dit soort afwijkingen direct worden weggegooid als

waardeloos en onbruikbaar. Maar in het geval van klimaat-"wetenschap" kunnen de modellen niet eens ter discussie worden gesteld. En als je het toch doet, word je een "klimaatontkenner" genoemd.

Zelfs deze enorme afwijking van de werkelijkheid van 200% weerhoudt regeringen van over de hele wereld er niet van om deze modellen en de daarop gebaseerde IPCC-aanbevelingen te gebruiken voor hun energiebeleid, -wetgeving en -projecten op lange termijn.

Terug naar de modellen

Wanneer de output van het model niet overeenkomt met metingen in de werkelijkheid, moeten een of meer van de regels die de simulatie definiëren verkeerd zijn. We moeten het probleem isoleren om het op te lossen.

Gelukkig is er onder de klimaatmodellen één positieve uitzondering. Het

Russische Imncm4 model volgt de werkelijke metingen vrij goed. Het verschil met alle andere klimaatmodellen is dat de Imncm4 modeldefinitie regels erkennen

dat CO2 slechts een zeer kleine factor is als het gaat om het modelleren van het klimaat. Het maakt gebruik van de kleinste CO

2-invloed (forcing) van alle modellen.

Imncm4 is de "klimaatontkenner" onder de klimaatmodellen. Maar het is het model dat het dichtst bij de werkelijke metingen in de buurt komt.

Het is volkomen duidelijk dat CO2 niet de belangrijkste klimaat "regelknop" is. Modellen die gebaseerd zijn op de CO2-hypothese voorspellen allemaal veel te veel opwarming, terwijl het enige model dat gebruik maakt van een kleine CO2-forcing veel beter aansluit bij metingen in de werkelijkheid.

Ik denk dat de tijd is aangebroken om een onafhankelijk onderzoek over deze problematiek te starten, gebaseerd op traditionele wetenschappelijke methoden.

Tom van Leeuwen, februari 2019.